Référencement IA : Comment l’Intelligence Artificielle Révolutionne le SEO

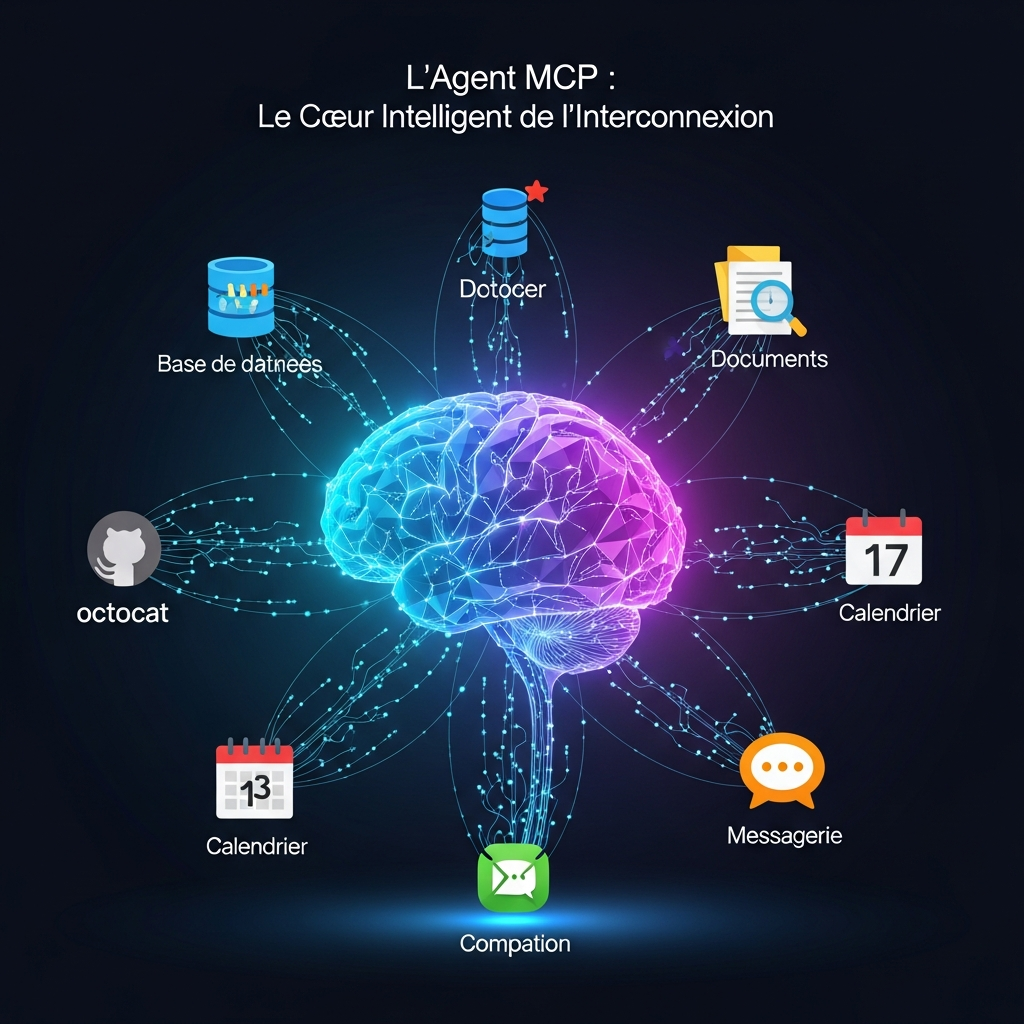

Le référencement naturel a toujours été une course contre la montre. Pendant que vous optimisez une page, vos concurrents en publient dix. Pendant que vous analysez vos backlinks, Google modifie son algorithme. L’intelligence artificielle change profondément cette dynamique. Elle permet désormais d’automatiser ce qui prenait des heures, d’identifier des opportunités invisibles à l’œil nu, et surtout, de prendre des décisions basées sur des millions de données en quelques secondes. Pourtant, l’IA ne remplace pas l’expertise humaine. Elle l’amplifie. Les outils d’IA générative produisent du contenu en masse, mais seule une stratégie pensée par un humain garantit la pertinence. Les algorithmes détectent des patterns, mais c’est vous qui comprenez votre audience. Cette symbiose entre machine et expertise crée une nouvelle ère du référencement, où l’efficacité rencontre l’intelligence stratégique. L’IA au service de la recherche de mots-clés Fini le temps où vous passiez des journées entières à compiler des listes de mots-clés dans des tableurs interminables. Les outils d’IA comme Semrush, Ahrefs ou les nouveaux assistants basés sur GPT analysent désormais l’intention de recherche avec une précision redoutable. Ils ne se contentent plus de vous donner des volumes de recherche, ils comprennent le contexte sémantique derrière chaque requête. Concrètement, l’IA identifie des clusters thématiques entiers à partir d’un seul mot-clé principal. Elle détecte les questions que se posent réellement vos prospects, pas celles que vous imaginez. Un client dans l’immobilier m’a raconté avoir découvert grâce à l’IA que ses prospects cherchaient « combien coûte un notaire » bien plus souvent que « frais de notaire », deux expressions qu’il pensait identiques. Cette nuance a transformé sa stratégie de contenu. Analyse prédictive des tendances L’intelligence artificielle ne se contente pas d’analyser le présent. Elle anticipe. En croisant des millions de données de recherche, les algorithmes de machine learning détectent les tendances émergentes avant qu’elles n’explosent. Cette capacité prédictive permet de créer du contenu sur des sujets qui connaîtront un pic de recherche dans les semaines à venir. Les outils d’IA analysent également la saisonnalité avec une granularité impossible à atteindre manuellement. Ils identifient non seulement les pics annuels évidents, mais aussi les micro-tendances hebdomadaires ou mensuelles propres à votre secteur. Cette intelligence temporelle vous positionne au bon moment, avec le bon contenu. Optimisation technique automatisée grâce à l’IA L’audit technique d’un site peut dévorer des dizaines d’heures. L’IA compresse ce travail en minutes. Elle crawle votre site comme Googlebot le ferait, mais va beaucoup plus loin en hiérarchisant automatiquement les problèmes par impact SEO réel. Plus besoin de deviner si cette balise canonical défaillante mérite votre attention immédiate ou peut attendre. Les plateformes d’analyse technique dopées à l’IA détectent des corrélations invisibles. Elles repèrent qu’un certain type de page avec une structure H2 particulière performe systématiquement mieux, même si ce pattern échappe à l’analyse humaine. Cette intelligence pattern-based permet d’extrapoler des bonnes pratiques propres à votre site, pas des généralités copiées-collées. Détection et correction des erreurs Core Web Vitals Google accorde une importance croissante à l’expérience utilisateur mesurée par les Core Web Vitals. L’IA excelle dans ce domaine précis. Elle identifie non seulement les pages problématiques, mais diagnostique automatiquement la cause racine : image non optimisée, script bloquant, problème de serveur. Certains outils vont jusqu’à générer le code correctif. Ils proposent des versions optimisées de vos images, suggèrent le lazy loading aux endroits stratégiques, ou recommandent des ajustements de cache. Cette automatisation technique libère un temps précieux pour vous concentrer sur la stratégie. Production de contenu SEO assistée par IA La génération de contenu par IA soulève des débats passionnés. La réalité terrain est plus nuancée que les discours catastrophistes ou béats. Oui, ChatGPT et ses concurrents produisent du texte en secondes. Non, ce texte brut n’est jamais prêt à publier tel quel sans perdre en qualité et en pertinence. L’intelligence artificielle devient puissante quand elle agit comme assistant, pas comme rédacteur. Elle génère des structures de contenu, propose des angles éditoriaux auxquels vous n’aviez pas pensé, reformule un paragraphe trop technique. Une agence avec qui je travaille a réduit de 40% son temps de production tout en améliorant son trafic organique, simplement en utilisant l’IA pour la phase de recherche et d’ébauche. Enrichissement sémantique automatique L’IA analyse vos contenus existants et identifie les manques sémantiques. Elle compare votre texte aux pages les mieux classées sur votre mot-clé cible et détecte les concepts, entités et cooccurrences absents de votre contenu. Cette analyse sémantique profonde dépasse largement les simples synonymes. Les outils de traitement du langage naturel comme les modèles BERT ou GPT comprennent le contexte global d’un texte. Ils suggèrent d’ajouter des sections entières sur des sous-thèmes connexes que Google s’attend à trouver dans un contenu exhaustif. Cette complétude sémantique influence directement votre capacité à ranker sur des requêtes complexes. Personnalisation de l’expérience utilisateur par l’IA Le SEO moderne ne se limite plus à plaire aux robots de Google. L’expérience utilisateur détermine de plus en plus le classement. L’intelligence artificielle permet de personnaliser cette expérience à une échelle impossible manuellement. Elle adapte le contenu affiché selon le comportement de navigation, la source de trafic, ou même l’heure de visite. Cette personnalisation va au-delà du simple test A/B. Les algorithmes de machine learning testent simultanément des dizaines de variations, identifient automatiquement les gagnantes, et les déploient progressivement. Un site e-commerce a multiplié par trois son taux de conversion en laissant l’IA optimiser ses pages catégories selon le profil visiteur. Optimisation du maillage interne intelligent Le maillage interne reste l’un des leviers SEO les plus sous-exploités. L’IA révolutionne cette pratique en analysant votre arborescence complète et en identifiant les opportunités de liens contextuels pertinents. Elle calcule le PageRank interne optimal et suggère précisément où ajouter chaque lien. Certaines plateformes vont jusqu’à générer automatiquement les ancres naturelles intégrant les bons mots-clés. Elles équilibrent intelligemment la distribution du jus SEO entre vos pages stratégiques, évitant les sur-optimisations tout en maximisant l’impact. Cette vision systémique du maillage dépasse largement ce qu’un humain peut gérer sur un site de plusieurs centaines de pages. Analyse de la concurrence amplifiée par l’IA Surveiller manuellement

Référencement IA : Comment l’Intelligence Artificielle Révolutionne le SEO Lire la suite »